설명가능한 인공지능 구현을 위한 적대적 신경망 기반 이상 탐지 알고리즘

Adversarial Neural Network-Based Anomaly Detection Algorithm for Implementing Explainable Artificial Intelligence

설명가능한 인공지능 (eXplainable Artificial Intelligence, XAI)

최근 인공지능 분야에서 중점적으로 연구되고 있는 중요한 영역 중 하나는 "설명 가능한 인공지능(eXplainable Artificial Intelligence, XAI)"이다. 전통적인 블랙박스형 인공지능 모델은 그 결과가 도출되는 과정을 사용자가 명확히 알 수 없다는 문제를 안고 있었다. 이러한 불투명성은 인공지능의 결과에 대한 신뢰성을 저해하는 주요 요인 중 하나로 지적되어 왔다. 특히, 인공지능이 산업 현장을 넘어 의료 및 보건 분야와 같은 인간의 생명과 직결된 영역으로 확대되면서, 인공지능의 결과를 이해하지 못하는 비전문가들의 참여가 필수적인 상황에서 XAI에 대한 수요는 점차 증가하고 있다.

XAI는 인간 사용자에게 인공지능이 학습한 방식과 결과 도출 과정을 이해할 수 있게 하는 일련의 방법과 기술을 포함한다. 이 기술은 인공지능이 어떤 방식으로 결론에 도달했는지 분석하거나, 결과를 보다 직관적이고 해석 가능한 방식으로 제공하는 것을 목표로 한다. 이를 통해 개발자는 시스템이 의도한 대로 작동하는지 검증할 수 있으며, 규제 요구사항을 충족하기 위한 투명성 또한 확보할 수 있다. 더불어, 인공지능의 결정에 영향을 받는 사람들이 그 결과에 대해 이의를 제기하거나 수정할 수 있는 기회를 제공함으로써, 보다 신뢰할 수 있는 인공지능 시스템의 구축이 가능해진다.

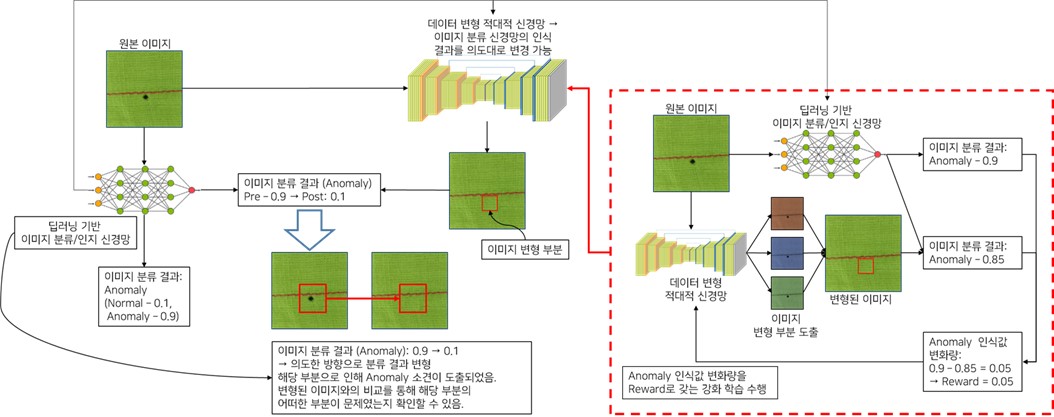

하지만 기존의 XAI 기법들은 데이터의 어떠한 부분이 영향을 미쳤는지를 확인하는 수준에 그치고 있다. 그리고 최근에는 자연어 처리 기술과 연계 하여 결과를 사용자가 알아볼 수 있는 형태로 제시하는 것에 중점을 두고 있다. 하지만 이러한 방식으로는 제한적인 정보만 제공 가능하다는 점에서 한계점이 분명하다고 볼 수 있다.

Figure 1 설명가능한 인공지능의 연구 사례[1-4]

적대적 생성형 신경망 (Generative Adversarial Network, GAN)

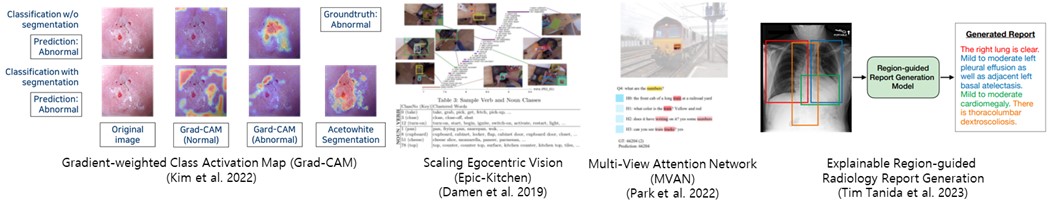

적대적 생성형 신경망(GAN, Generative Adversarial Network)은 게임 이론의 미니맥스 두 플레이어 게임 구조를 이용해 생성 모델을 학습하는 방식이다. GAN은 두 가지 주요 구성 요소, 즉 생성자(Generator)와 구분자(Discriminator)로 이루어져 있다. 생성자는 가상의 데이터를 생성하고, 구분자는 이를 실제 데이터와 비교해 진위를 판별한다. 생성자는 구분자를 속이기 위해 점점 더 현실적인 데이터를 만들어내며, 구분자는 이를 구별하기 위해 더욱 정교해지는 방식으로 상호 경쟁하며 발전한다.

이 과정은 게임 이론의 최적화 문제로 볼 수 있으며, 생성자는 손실 함수를 최소화하고 구분자는 이를 최대화하려는 방식으로 학습이 이루어진다. 이러한 경쟁 구조 덕분에 GAN은 매우 현실적인 데이터를 생성할 수 있는 능력을 갖추게 된다.

GAN의 의의는 이미지, 비디오, 텍스트 생성 등 다양한 분야에서 현실적이고 고품질의 데이터를 생성할 수 있다는 점에서 크게 주목받고 있다. 특히 예술, 의료, 콘텐츠 생성 등 여러 산업에서 혁신적인 가능성을 제시하며, 인공지능의 창의적 활용을 더욱 확장시키는 중요한 기술로 평가받고 있다. GAN은 인공지능의 생성 능력 향상에 기여하며, 앞으로도 다양한 분야에서 그 응용 가능성이 지속적으로 확대될 전망이다.

최근 적대적 생성형 신경망과 같은 생성형 AI 기술을 설명가능한 인공지능에 적용하려는 시도가 진행되고 있다. 데이터를 다양하게 변형시키면서, 변형된 데이터에 대해 학습된 신경망이 어떻게 반응하는지를 분석하여, 해당 학습된 신경망이 어떻게 작용하는지를 파악하는 방식이다.

Figure 2 적대적 생성형 신경망의 개념 [5]

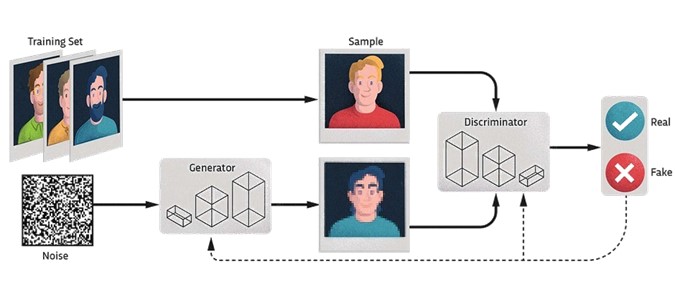

본 연구에서 제안하는 알고리즘

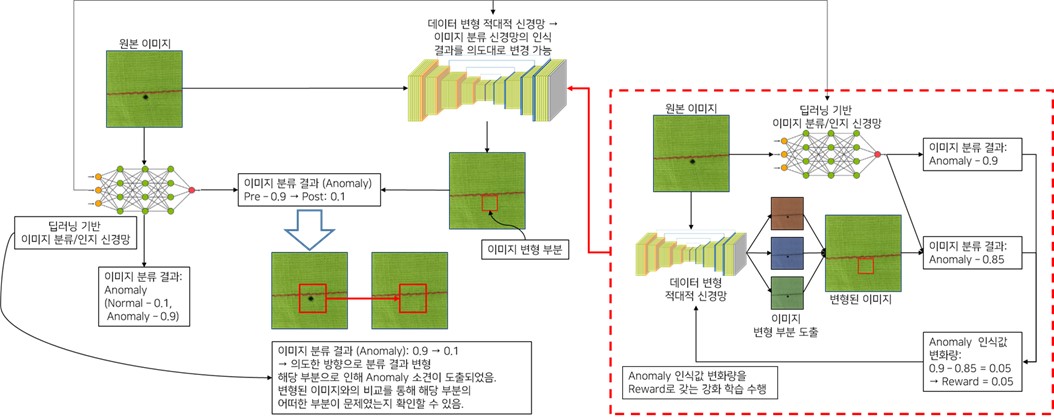

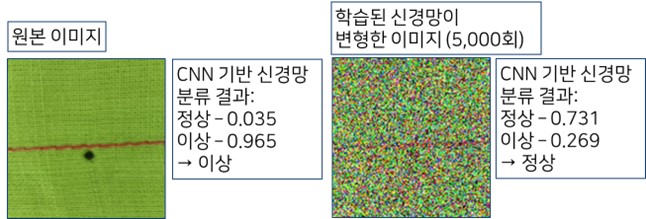

본 연구에서 제안하는 알고리즘은 아래와 같다. 적대적 생성형 신경망이 Generator와 Discriminator로 구별되어 학습되는 것에서 모티브를 얻어, Discriminator를 Classifier로 대체하는 것이다. 이를 통해 Generator는 Discriminator로 대체된 Classifier를 속이는 방향으로 이미지를 변형시키도록 학습을 진행하는 것이다. 이를 위하여 변형 전 이미지와 변형 후 이미지의 판별 값의 변화량을 Reward로 하는 강화학습을 통해 해당 Generator를 학습시키도록 하였다. 얼룩이 있는 직물에 대해서, 사전 학습된 신경망은 (0.035, 0.965)로 이상으로 판단하였다. 이를 Segnet기반 이미지 변형 신경망을 통하여 변형을 시도하였으며, 변형된 이미지는 사전 학습된 신경망은 (0.731, 0.269)로 정상으로 판단하였다. 이 과정에서 천 부위에 대해서는 임의의 조작이 가해지고 있는 것으로 보아, 판단에 영향을 주지 못하는 것을 확인할 수 있었으며, 얼룩 부분은 최대한 지워지는 방향으로 변형이 가해지고 있었다. 또한 실 부분은 유지하는 방향으로 이미지 변형이 가해지고 있었다. 이러한 변형 방향을 통해 사전 학습된 분류 신경망이 어떠한 부분에서 판단에 영향을 받고 있는지 확인할 수 있었다.

Figure 3 본 연구에서 제안하는 알고리즘

Figure 4 본 연구에서 제안한 알고리즘을 통해 도출된 이미지 변형 및 판별 결과

맺음말

설명가능한 인공지능은 인공지능 기반 분류/인식 기술의 신뢰성 담보 등을 위하여 필수적인 기술이다. 본 연구는 사용자에게 납득 가능한 다양한 근거를 제공하는 것을 목표로 하고 있으며, 이를 통해 의료, 보건 등 다양한 분야에서 인공지능의 판단 결과에 대한 전문가들의 신뢰성을 높이는 데 기여할 것으로 기대된다.

Reference

1. Kim, J., et al., Convolutional neural network-based classification of cervical intraepithelial neoplasias using colposcopic image segmentation for acetowhite epithelium. Scientific Reports, 2022. 12(1): p. 17228.

2. Dhiman, C. and D.K. Vishwakarma, A review of state-of-the-art techniques for abnormal human activity recognition. Engineering Applications of Artificial Intelligence, 2019. 77: p. 21-45.

3. Park, S., et al., Multi-View Attention Network for Visual Dialog. Applied Sciences, 2021. 11(7): p. 3009.

4. Tanida, T., et al. Interactive and explainable region-guided radiology report generation. in Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2023.

5. Exploring the Fascinating Realm of Generative Adversarial Networks (GANs). Available from: https://www.linkedin.com/pulse/exploring-fascinating-realm-generative-adversarial-networks-kaurav.

대표이사: 유병현 / 사업자등록번호: 220-82-60063

Copyright© 2023. Society for Computational Design and Engineering. All rights