서론

디지털 트윈뿐만 아니라 게임, 메타버스, 영화 등에서 3D 모델은 이제 필수적으로 활용되는 기본 자원에 가깝습니다. 하지만 만들기가 무척 까다롭고 생산 시간 또한 만만치 않습니다. CAD 툴을 깊이 있게 활용할 수 있는 전문가가 오래 작업한 결과물이 필요할 뿐만 아니라, 그래픽스 기술에 대한 이해까지 필요한 분야이기 때문입니다.

오늘날 Midjourney, Stable Diffusion 등을 비롯한 다양한 AI 솔루션들이 적극적으로 활용이 논의되는 것을 보면, 3D 분야에서도 머지않아 이러한 기술들이 활용될 것을 기대해 볼 수 있을 것 같습니다. 이러한 측면에서 현재 AI가 3D 복원 분야에서 어느 수준에 이르렀는지를 살펴보고, 앞으로 어떤 방향으로 나아가야 할지에 대해 논의하고자 합니다.

3D 형상 복원을 위한 AI 기술의 현재

3D 모델을 분류하는 방법은 많겠지만, 여기서는 ‘실존하는 대상을 표현하기 위한’ 3D 모델과, ‘실존하지 않는 대상을 상상해서 만들어 낸’ 3D 모델로 구분해 보겠습니다.

형상 복원 기술 개요

실존하는 3차원 형상을 디지털화하기 위해 쓰이는 기술을 통상 3D 복원(Reconstruction)이라고 합니다. 3D 복원 기술이 필요한 분야는 매우 다양한데요, 크게는 지형이나 개방공간과 같이 상대적으로 넓은 곳을 복원해야 하는 분야부터, 작게는 실내 공간이나 단일 사물의 복원이 필요한 분야도 있습니다.

|

개방 공간 형상 |

건설, 군사 시뮬레이션, 지도

및 네비게이션, 레이싱 시뮬레이터, 자원탐색 등 |

|

실내 공간 형상 |

가상 스튜디오, 영화 제작,

부동산, 실내 인테리어, 디지털 트윈, 산업로봇 자율주행 등 |

|

단일 객체 형상 |

제품 광고, 실사 기반 게임/영화 소품 제작, 버추얼 휴먼 제작 등 |

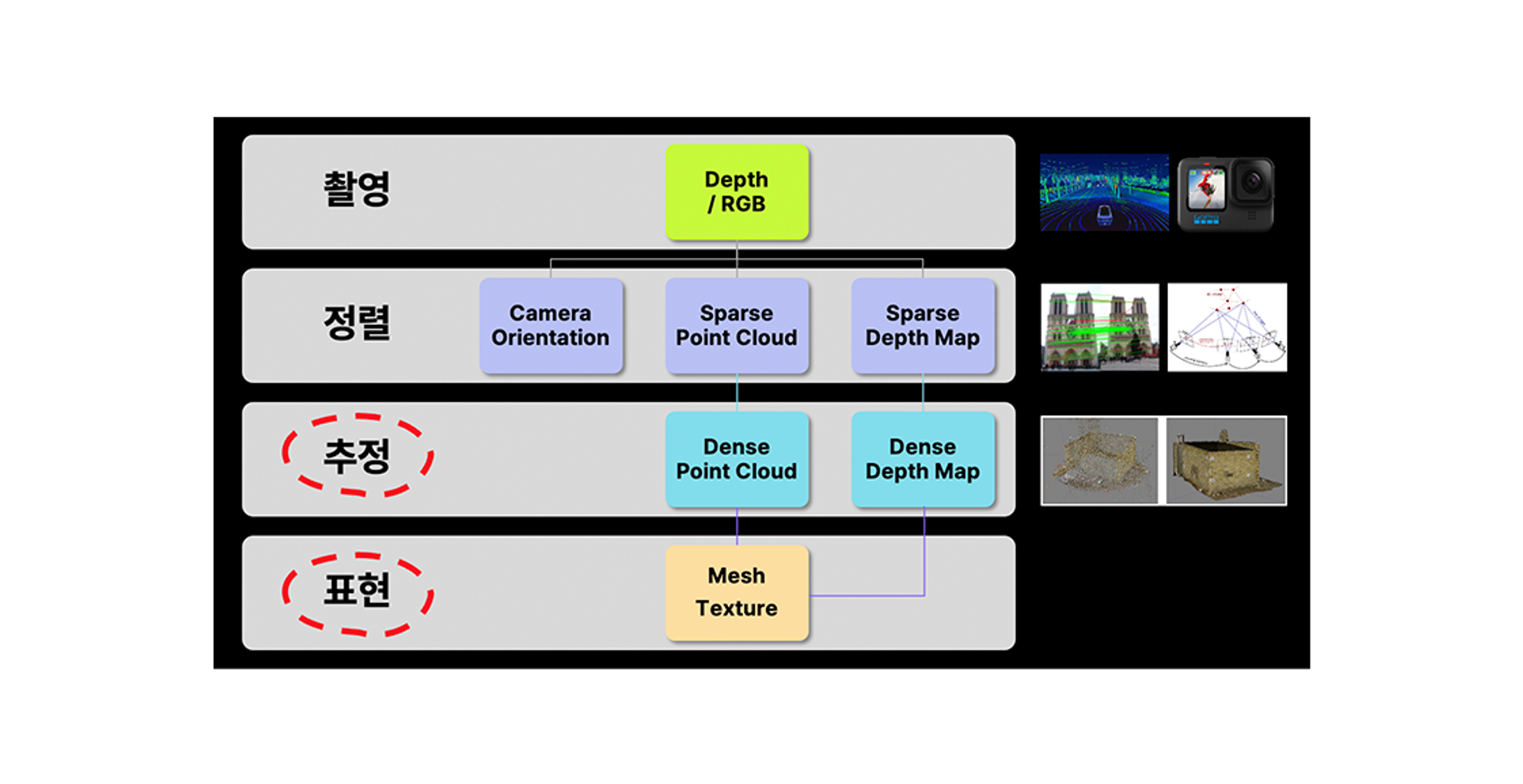

일반적으로 이러한 3차원 형상 복원에는 사진 측량 (Photogrammetry) 방법이 사용되고 있습니다. 문자 그대로 여러 장의 사진을 이용해 공간을 측량해서 형상을 복원하는 개념입니다. 이때, 측량에 활용할 수 있을 정도로 상대적으로 확실한 위치 정보는 통상 듬성듬성(Sparse)하기 때문에, 일반적으로 이 정보를 빽빽(Dense)하게 만들기 위해 추정하는 단계를 거쳐야 하죠.

Neural Radiance Fields의 활용

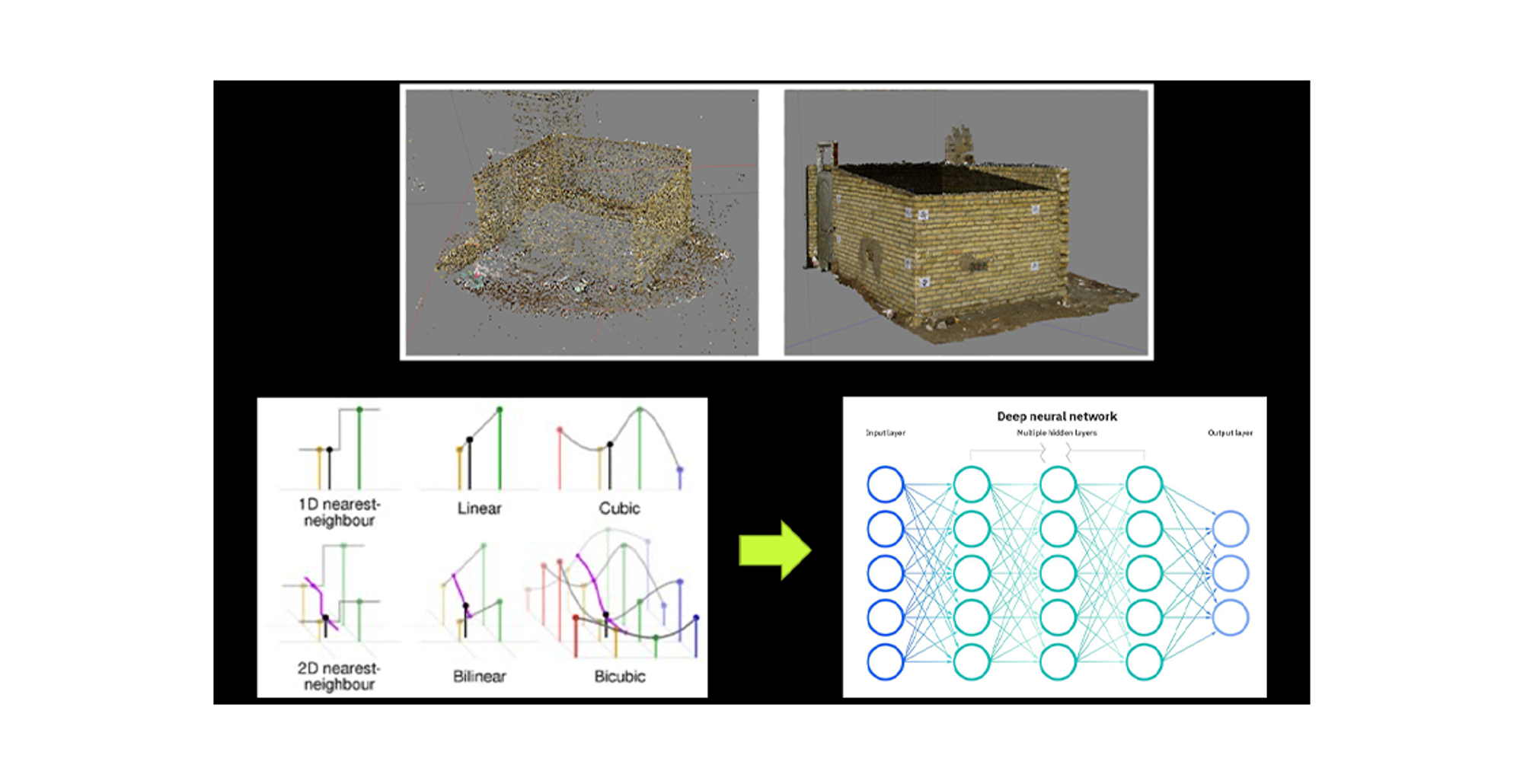

이 추정 단계에서 뉴럴 네트워크를 활용한 학습을 활용할 수 있다는 것이 현재 3D 복원 AI 연구의 주된 접근방법이라고 할 수 있습니다. 이 문제를 풀기 위해 효과적인 방법을 제시한 연구가 2020년 발표된 NeRF (Neural Radiance Fields) 방법입니다. NeRF는 그동안 알고리즘적인 접근으로 해결해 왔던 듬성듬성(Sparse)한 공간 정보를 빽빽(Dense)하게 만드는 문제에서 뉴럴 네트워크를 활용해 큰 성공을 거두었습니다. 현재 학계에서 3D AI 방법론의 대부분은 NeRF의 핵심 아이디어를 빌딩 블록처럼 활용하고 있다고 해도 과언이 아닙니다.

리콘랩스의 3차원 복원 솔루션은 이 NeRF 방식을 활용해 종래의 사진측량 기반 3차원 복원 성능을 혁신했습니다. 솔루션 개발 초기부터 AI를 활용할 수 있는 방법론으로서 NeRF를 주목해 연구를 진행하였고, 현재 일반 RGB 영상 기반 형상 복원에서 상업용으로는 세계 최고 수준의 솔루션을 제공하고 있습니다.

기존 사진측량 방식에서는 주어진 사진으로부터 추출할 수 있는 정보가 너무 듬성듬성하면 보간이 어려웠습니다. 따라서, 구멍이 생기거나 표면이 매끄럽게 나오지 않은 결과로 이어졌는데, 특히, 단일 색상 표면이나 금속 등 반사성 재질에서 이러한 문제가 흔히 발생했습니다. 이러한 문제 때문에 사진측량을 통한 복원 기술은 대부분의 실생활 제품에 활용되기 어려웠습니다. 리콘랩스는 NeRF를 응용한 AI 추론을 고도화해서 이러한 문제를 획기적으로 개선한 솔루션을 개발하였고 (왼쪽), 이를 상용화하여 웹 서비스로 제공하고 있습니다. (오른쪽; https://3dpresso.ai )

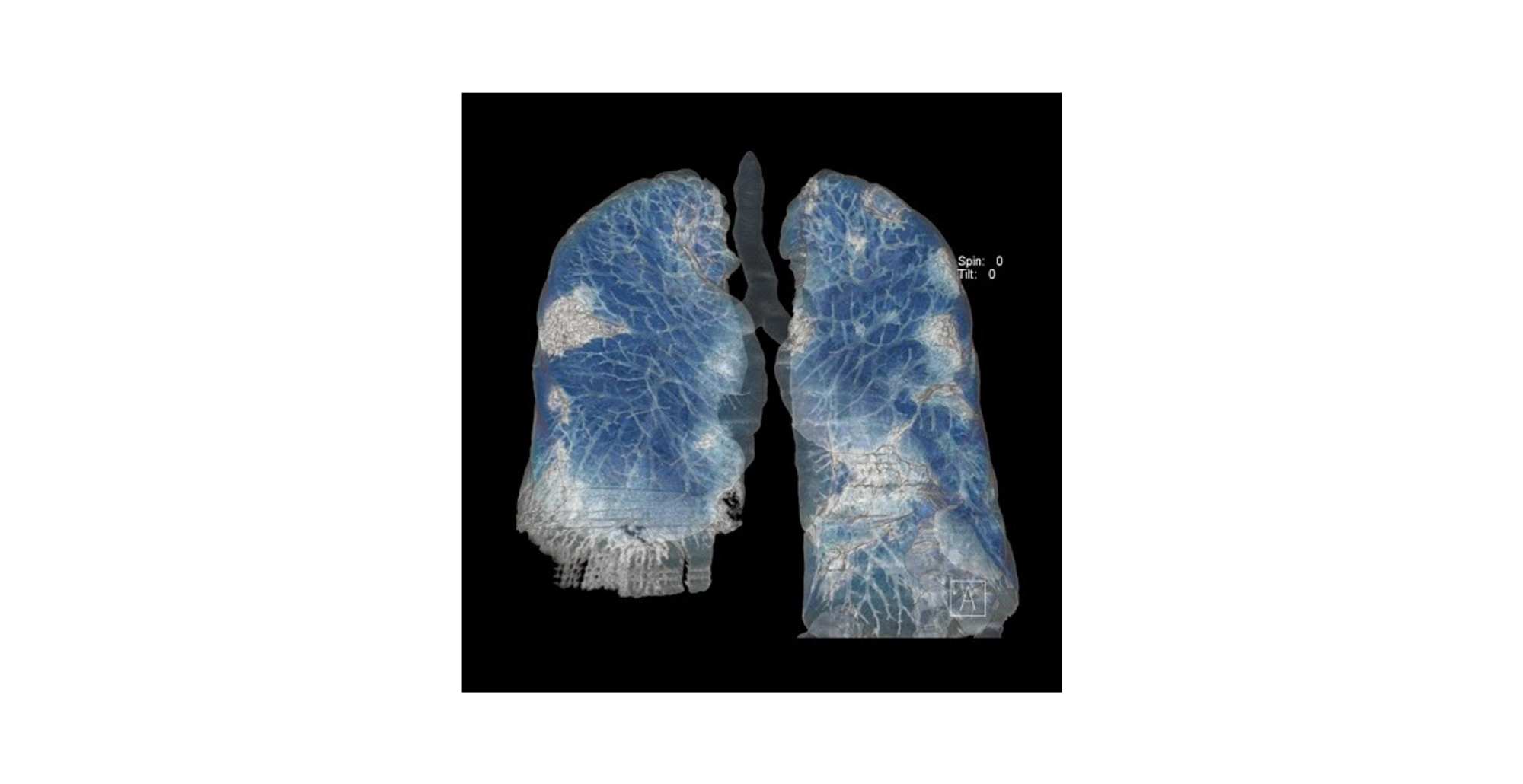

배경이 되는 기술인 NeRF를 설명하기에 앞서 잠시 CT 데이터를 그리는 방식인 볼륨 렌더링(Volume Rendering)을 살펴보겠습니다. 볼륨 렌더링은 저마다의 색상과 투명도가 있는 작은 정육면체가 잔뜩 있다고 할 때, 이 정보를 화면의 픽셀로 그려내기 위해 연장선상에 있는 각각의 정육면체의 색상들을 투명도를 고려해서 더해주어서 2차원에 그리는 방식이죠. 이미지 편집할 때에 레이어 별로 투명도를 적용해 알파 블렌딩(Alpha Blending)하는 것과 비슷한 개념입니다.

NeRF는 위에서 설명한 볼륨 렌더링 과정, 즉 3차원 정보로부터 2차원 사진을 그려내는 과정을 거꾸로 접근한 것입니다. 즉 알고 있는 3차원 정보를 2차원에 그려내는 것과 반대로, 2차원 정보를 바탕으로 주어진 사진의 픽셀을 그리기 위해 필요한 경로에 있는 정보들을 뉴럴 네트워크를 통해 학습시키는 것이지요. 간단히 표현하자면 NeRF는 추론한 정보(색상, 밀도)로 그려낸 픽셀과 실제 사진의 픽셀을 반복 비교하는 학습을 시켜 공간 전체를 표현하는 함수를 뉴럴 네트워크로 만드는 방식입니다.

3D 복원 기술의 미래

NeRF의 아이디어를 응용하면, 2차원 정보를 통해서 3차원 형상을 복원하는 성능을 크게 끌어올릴 수 있습니다. 하지만 이에 그치지 않고 앞으로 더 많은 발전이 이루어질 수 있는 가능성이 큰 분야이기도 합니다. 크게 다음과 같은 방향에서 머지않아 많은 변화가 있을 것으로 전망하고 있습니다.

• 학습 및 표현의 효율화

• 형상 이해를 통한 복원, 조합 및 생성

3D Gaussian Splatting

지난 8월, NeRF 방식을 응용한 연구에 또 다른 혁신을 가지고 온 연구가 발표되었습니다. 그래픽스 분야 최고 권위 학회인 SIGGRAPH에서 최고 논문상을 수상한 논문인 <3D Gaussian Splatting for Real-Time Radiance Field Rendering>입니다. (이하 Gaussian Splatting)

이 연구는 크게 두 측면에서 NeRF 방식의 3차원 표현을 혁신했다고 평가할 수 있습니다.

1. Neural Network 대신 점 구름(Point Cloud)을 최적화해서 3D 재구축 과정이 효율적

2. 결과물이 AI 모델이 아닌 점 구름 집합이기 때문에, 결과물의 활용이 용이

앞서 NeRF는 이름에서 유추할 수 있듯, 공간을 Field로 보고 공간 전체를 다루는 방식으로 AI를 학습시켰습니다. 때문에 사실상 주어진 공간의 많은 부분을 차지하는 비어 있는 공간을 학습하는 데에도 많은 자원을 사용해야 했죠. Gaussian Splatting은 이러한 문제를 점 구름을 활용해 해결했습니다. 다시 말해, 공간을 표현하기 위해 꼭 필요한 위치에 점 구름을 그려내도록 하는 전략을 취했죠.

비유하자면 마치 공간상에 m&m’s 초콜릿 같은 색색의 구름 덩어리(3D Gaussian) 들을 많이 흩뿌린(Splat) 다음에, 주어진 사진들과 일치한 그림을 그릴 수 있도록 구름들의 위치, 크기, 투명도, 색상 등을 바꿔가는 방식으로 생각할 수 있습니다.

별도의 AI 모델을 학습시키는 대신 점구름의 크기, 위치와 색상을 직접 바꿔가기 때문에 3D 형상 재구축을 매우 빠르고 효율적으로 수행할 수 있게 되었습니다. 뿐만 아니라 생성 결과물 역시 AI모델이 아닌 점구름 파일로 생성되는데, 이는 기존 그래픽스 프로그램에서 곧바로 활용할 수 있는 파일방식입니다. 때문에 별도의 AI 모델의 배포 없이도 3차원 복원 결과물을 직접 기존의 어플리케이션을 수정해서 활용할 수 있습니다.

현재 학계뿐만 아니라 Unity, Unreal 등의 기존 3D 어플리케이션 업계에서도 Point Cloud를 활용한 공간 표현 방식이 NeRF를 혁신하고, 나아가 Mesh의 한계를 다양한 측면에서 넘어설 수 있는 3차원 복원 방식으로 전망하고 있는 것으로 보입니다.

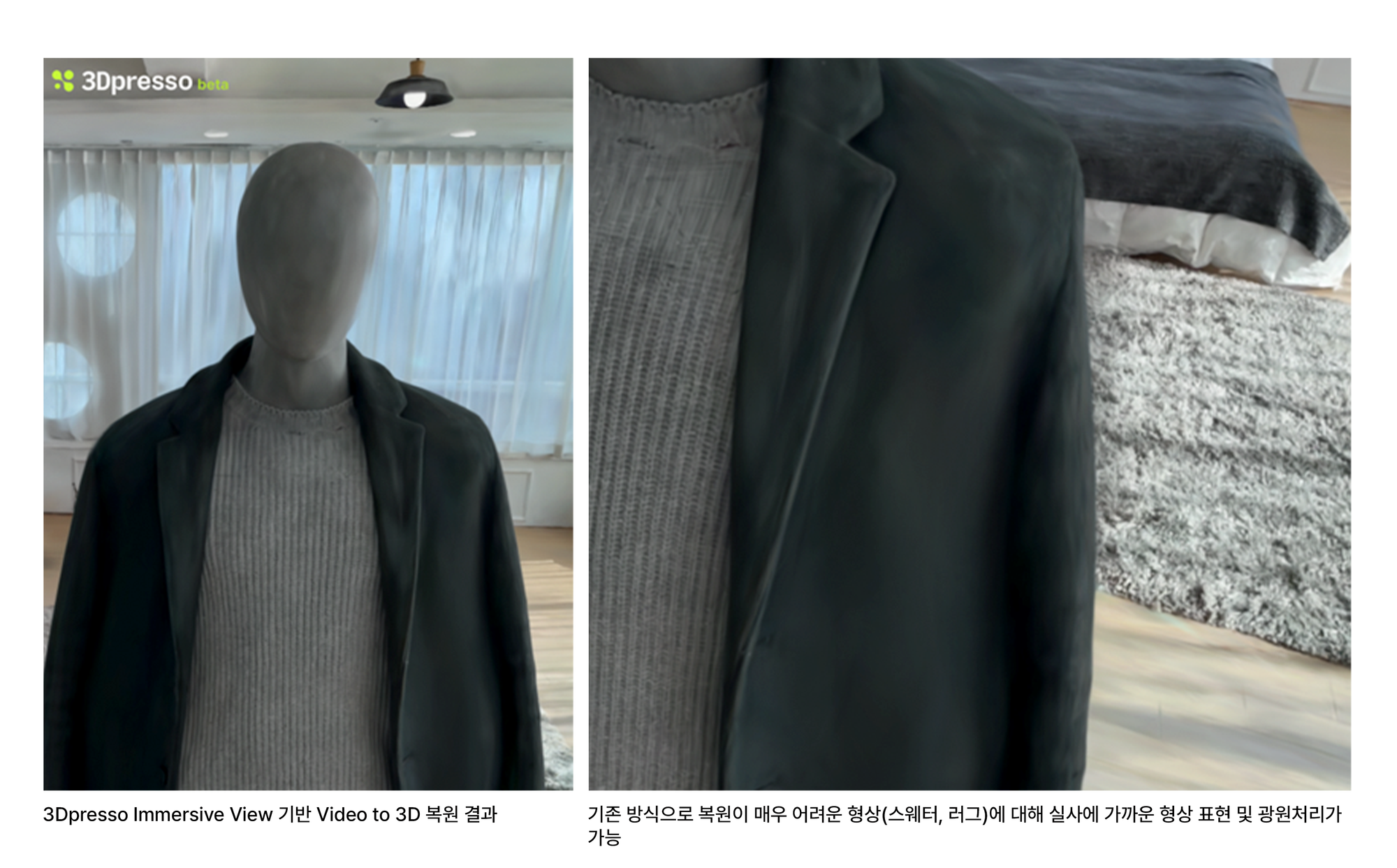

리콘랩스는 기존의 3Dpresso 서비스 내 Video to 3D 복원 솔루션 개발 과정에서 축적된 엔지니어링 노하우에 더해, 이 같은 최신 학계의 혁신적인 아이디어를 접목한 한 차원 더 발전된 3D 복원 솔루션 Immersive View를 공개할 예정입니다.

Immersive View의 결과물은 기존 Mesh와 이미지 형식 텍스처 방식으로는 복원하기 매우 어려운 질감과 광원 표현이 가능할 뿐만 아니라, 웹 사이트를 통해 곧바로 사용자의 스마트폰에서 확인이 가능하여 확장성이 매우 높은 장점을 가지고 있습니다. 저희는 이러한 혁신적인 3차원 복원 솔루션이 앞으로 전자상거래, 가상 스튜디오 등에서 광범위하게 활용될 수 있을 것으로 기대하고 있습니다.

형상 이해를 통한 복원, 조합 및 생성

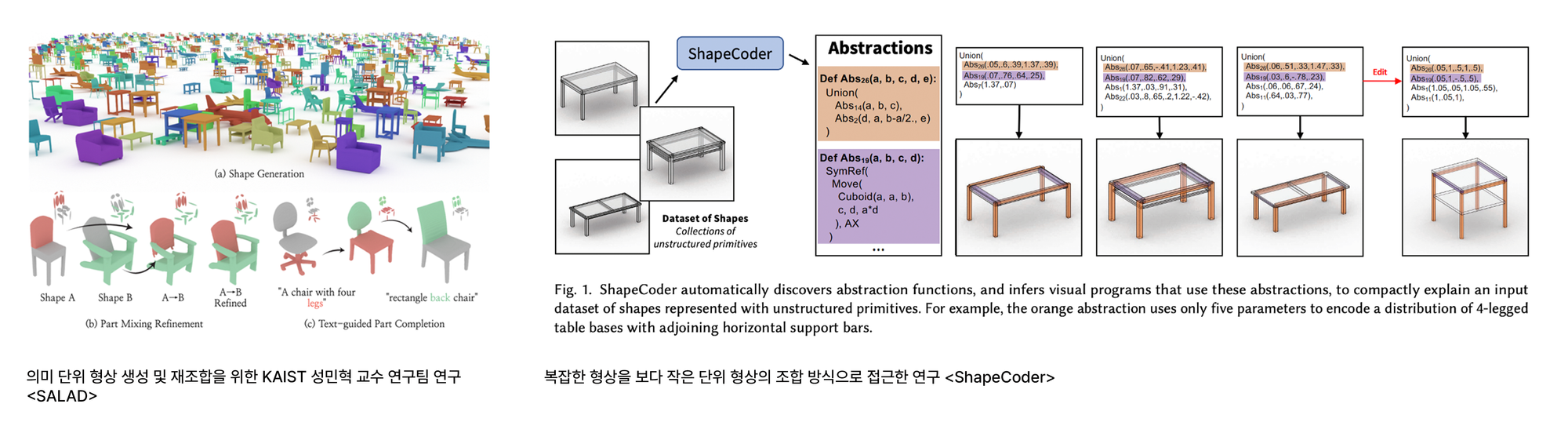

한편 형상을 단순히 복원하는 것에 그치지 않고, 형상에 대한 이해를 바탕으로 한 복원, 조합 및 생성 분야를 혁신하기 위한 연구가 앞으로 활발히 진행될 것으로 보입니다.

현재 3차원 복원 기술은 단순히 비유하자면, 형상의 겉표면만을 복원하고 있다고 표현해도 무방합니다. 이는 사실 겉보기에 같게 보이도록 복원하는 것조차 쉽지 않은 문제였던 측면도 크다 할 수 있겠습니다. 하지만 현재 AI를 활용한 형상 복원 성능이 점점 발달하여 실사에 가까워짐에 따라, 이를 활용하기 위한 연구가 자연스럽게 발전할 수 있게 되었습니다.

예를 들면, 인체를 복원한다고 했을 때, 결과물을 현장에서 애니메이션 등에 실제로 활용하기 위해서는 형상이 의미 단위 (팔, 다리, 얼굴, 몸통 등)으로 분할되어야 합니다. 이를 위해서는 단순히 인체의 표면을 표현하기 위한 점의 집합으로 복원하는 것에 그치지 않고 이상적으로는 팔, 다리, 몸통, 얼굴 등의 하위 구조로 분할해서 복원될 필요가 있습니다. 학술적으로는 2D 이미지에서 고도화된 semantic segmentation 분야를 3차원 복원에 응용하기 위한 방향으로 기술이 발전할 것으로 생각됩니다.

이런 의미단위를 고려한 복원이 가능하게 된다면, 다음 단계는 복원된 결과물의 의미단위 재조합 및 생성이 될 것입니다. 우리가 어떠한 3차원 형상을 만든다고 할 때, 우리는 vertex 나 point의 조합으로 형상을 이해하지 않습니다. 의미단위로 구분된 덩어리들의 조합으로서 형상을 이해하는 것이 보통이겠지요. 3차원 형상을 생성하기 위한 연구는 이러한 방향으로 발전될 가능성이 큽니다. 실제로 올해 이러한 방향의 연구들이 많이 진행되고 있는 것을 최근 발표된 여러 논문에서 확인할 수 있었습니다.

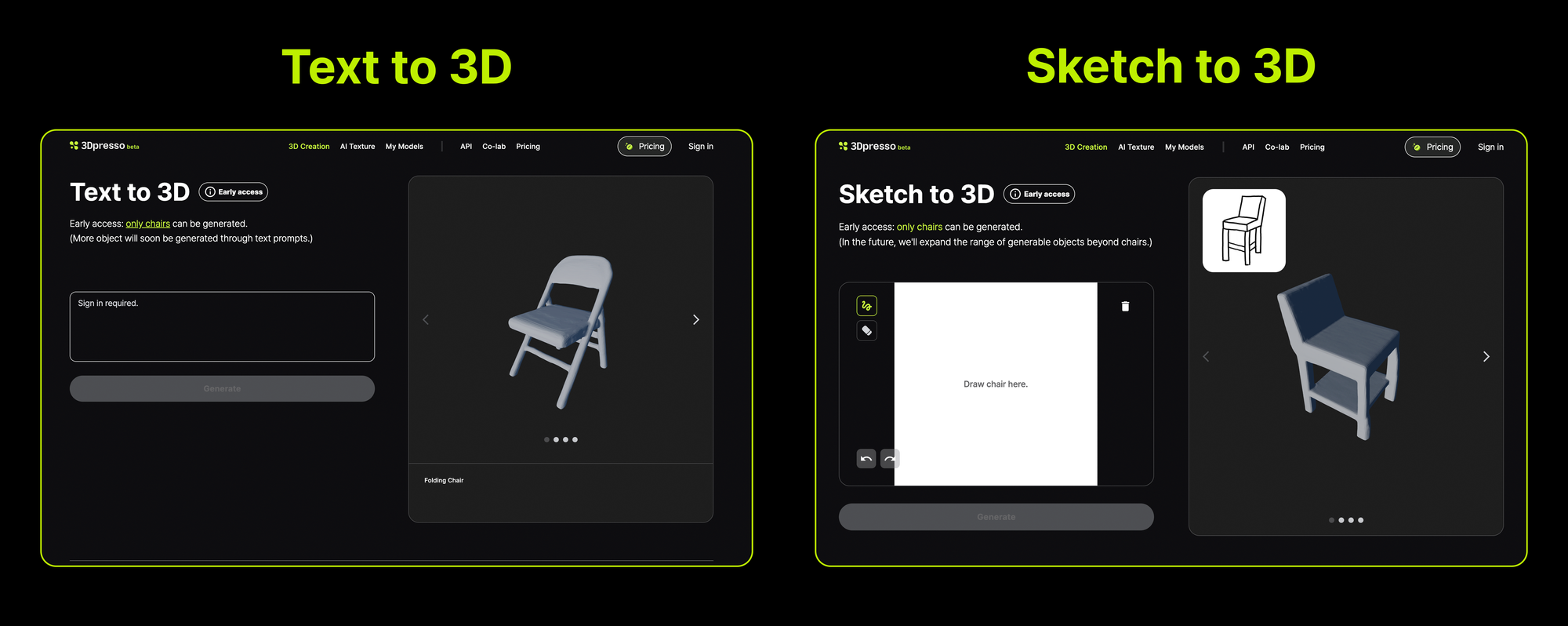

리콘랩스는 이러한 흐름에 발맞추어, 의미 이해 기반 형상 생성 분야 최신 학술 연구 결과의 상용화 가능성을 선제적으로 탐색하고 있습니다. 3Dpresso 서비스 내 Early access 형태로 제공하고 있는 언어, 스케치 기반 형상 생성 서비스는, 형상 복원 및 생성 기술이 앞으로 발전하게 될 방향성에 대한 리콘랩스의 이러한 비전을 담고 있습니다.

맺음말

3차원 형상 복원 기술은 최근 AI 기술의 발전 및 혁신을 바탕으로 빠르게 발전하고 있습니다. 기존의 복원 방법론이 가졌던 많은 한계를 뉴럴 네트워크를 활용한 아이디어를 통해 극복해 나아가고 있을 뿐만 아니라, 전통적인 표현 방식을 대체하거나 상호 보완할 방식으로 고려될 수 있는 방식 또한 제안되고 있습니다. 또한 앞으로는 복원 과정에 있어 의미 단위를 이해하고 나아가 조합, 생성할 수 있는 방향으로 연구가 발전할 것으로 예상됩니다. 저희 리콘랩스는 이러한 빠른 기술 발전에 발맞추어, AI를 활용한 3차원 형상 관련 솔루션을 고도화, 상용화하여 관련 분야 선도 기업으로 발전해 나아가고자 합니다.

대표이사: 유병현 / 사업자등록번호: 220-82-60063

Copyright© 2023. Society for Computational Design and Engineering. All rights