딥러닝 기반의 카메라 자세 추정 및 스마트 글래스를 이용한 혼합현실

지도교수 : 고광희 교수

2023년 6월 Apple Vision Pro가 공개된 뒤, 오랜만에 출시되는 새로운 카테고리의 제품에 대해 많은 사람이 열광하였다. 특히, 최근에 이를 구매하는 것이 가능해졌고, 실제 사용기와 더불어 이를 구성하는 기술적 요소들을 설명하는 영상들이 많아졌다. 애플은 AR (증강현실), VR (가상현실), MR (혼합현실), XR (확장현실)이라는 용어 대신 공간 컴퓨팅이라는 단어로 위의 기기를 설명하였지만, 개략적인 작동 원리는 MR/VR과 유사하다고 볼 수 있다.

여기에서 주목해야 할 것은 혼합현실인데, 혼합현실이란 현실 공간과 가상 공간의 조화라는 특징 하에 다양한 사용자에게 새로운 경험을 제공할 수 있는 기술로서, 다양한 산업 영역에서 기존의 기술로 해결하지 못했던 여러 문제를 해결할 수 있다는 독창성으로 인해 많은 연구자에게 주목받고 있는 기술이다. 특히, 사용자에게 새로운 경험을 제공하기 위한 몰입감 있는 혼합현실을 구현하기 위해 가상의 콘텐츠를 투사 및 증강하기 위한 대상 객체가 어떤 것인지 정확히 인식할 수 있는 기술과 해당 객체를 사용자 (카메라)가 어떤 자세로 바라보고 있는지 추정할 수 있는 기술이 필요한데, 여기에서 사용자의 자세란 3차원 위치와 3차원 회전 정보를 포함하는 6차원 값이다.

마이크로소프트사의 Azure Kinect와 인텔사의 RealSense와 같은 3차원 스캐너를 사용하게 되면 객체 인식과 자세 추정이 쉽지만, 잡음 처리 등의 데이터 분석 및 처리 과정이 반드시 수반되어야 한다는 단점이 존재한다. 특히, 자세를 추정하기 위해 ICP (Iterative Closest Point) 기반의 정합 기술을 적용하기 때문에 굉장히 처리 속도가 느리며 정확도 또한 낮다. 다른 접근 법으로 딥러닝 기술을 적용하게 되면, 3차원의 깊이 정보 없이 2차원 이미지만으로도 객체 인식과 자세 추정을 동시에 실시간으로 할 수 있다는 장점이 존재하지만, 정확도 측면에서 여전히 개선해야 할 여지가 남아있다.

제안하는 연구는 객체 인식과 6차원 자세를 동시에 진행하는 EfficientPose [1] 딥러닝 기술에 이미지 증강 기법을 적용하여 6차원 자세 추정의 정확도를 향상하는 방법에 관한 연구이며, 향상된 자세 값을 기반으로 스마트 글래스를 착용한 사용자를 위한 혼합현실 환경을 구축하는 예제를 담고 있다. Fancy PCA [2]는 객체 식별 (image classification) 분야에서 널리 쓰이는 기술이며, RGB 채널에 대한 공분산 행렬을 주성분 분석 기법을 적용하여 획득한 고유값과 고유 벡터로 구성된 아주 작은 값을 각 채널에 더하는 과정 (그림 1.)을 통해 과적합을 방지하는 데 도움이 되는 것으로 알려져 있다.

EfficientPose에는 이미 회전, 위치, 스케일에 대한 6D 증강 기법과 가우시안 잡음을 추가하는 색상 영역의 증강이 포함되어 있어 정밀한 6차원 자세 추정이 가능하다. 하지만, 6차원 자세를 추론하기 위한 딥러닝 학습 데이터셋을 구축할 때, 데이터의 개수가 적고 조명 등의 변화로 인해 객체의 고유한 텍스쳐 정보가 균일하지 않은 특성이 네트워크에 영향을 주는데, 이러한 한계를 극복하는데 Fancy PCA가 유효할 것 추정되기에 EfficientPose의 입력단에 Fancy PCA를 추가 모듈로 구성하였고, 네트워크의 아키텍쳐는 변경하지 않았다.

그림 1. 원본 이미지 (왼쪽)와 Fancy PCA (x2000)가 적용된 이미지 (오른쪽)

학습 및 평가를 위해 사용된 데스크탑은 Windows 10 (64 bit), Intel(R) Core(TM) i7-12700 CPU @ 3.60GHZ, Memory 32 Gb, SSD 1.0 TB, Geforce RTX 3080 Ti이며, 사용된 데이터셋은 Linemod이다. 평가 지표는 2차원 재투영 오차 (2D), ADD (6D), 그리고 5cm5deg를 사용하였고, 단위는 [%]이다.

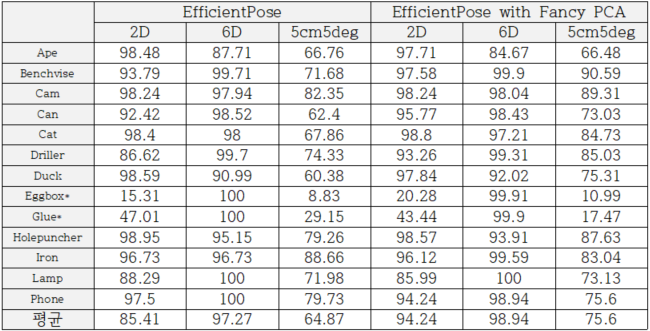

표 1. 성능 결과

EfficientPose의 네트워크 아키텍쳐는 EfficientDet [3]을 6차원 자세 추정으로 확장한 것이며, 특징 피라미드로부터 이미지의 특징을 잘 추출했기에 표 1과 같이 2D, 6D, 그리고 5cm5deg 오차가 각각 85.41 [%], 97.27 [%], 그리고 64.87 [%]라는 높은 성능을 보여주었다. 특히, EfficientPose는 추론된 이미지 특징점으로부터 3차원 모델과의 대응 관계를 PnP 알고리즘 [4]의 입력으로 6차원 자세값을 추정하는 간접적 방법이 아닌, 3차원 모델 없이 직접 자세를 추정하는 방법이므로 더 간편하며, 높은 정확도를 갖는 방법이었다. 게다가 계산 시간은 총 27 [FPS]로 실시간인 30 [FPS] 준하였으므로 혼합현실과 연계되면 충분히 좋을 기술로 생각할 수 있었다. 다음으로 네트워크 구조의 변화 없이 Fancy PCA를 네트워크의 입력 모듈로 추가하게 되면, 2D, 6D, 그리고 5cm5deg 오차가 각각 94.24 [%], 98.94 [%], 그리고 75.6 [%]로 기존에 비해 성능이 향상된 것을 알 수 있었다. 수치 변화는 2D, 6D, 그리고 5cm5deg 오차를 기준으로 각각 8.83 [%], 1.67 [%], 그리고 10.73 [%] 씩 증가한 것을 알 수 있었고, 특히 2D와 5cm5deg에서 상당한 정확도 향상이 있던 것을 알 수 있었다.

결과적으로, 주성분 분석 기반의 색상 영역 증강 기법이 유효했음을 확인했으며, 높은 정밀도를 요구하는 산업 분야에서도 잘 활용할 수 있는 기술임이 증명되었다고 볼 수 있다. 특히, 혼합현실 기술에 적용했을 때 가상의 콘텐츠가 2차원 이미지 내의 객체에 정확히 투사되어야 하는 문제에서 2차원 재투영 오차를 뜻하는 2D의 성능 향상이 크게 이루어져 94 [%]라는 높은 정확도를 보여줬던 것이 꽤 의미 있는 결과라고 볼 수 있었다. 추가적으로 실제 혼합현실 구현을 위해 벤치마크 데이터셋을 직접 네트워크에 입력하는 것이 아닌 스마트 글래스의 카메라로 촬영된 벤치마크 데이터셋 영상을 네트워크의 입력으로 제공한 실험에서도 높은 정확도 (그림 2.)를 보여주었다.

그림 2. 스마트 글래스의 입력 이미지와 네트워크 추론 결과

결론적으로, 이미지 식별 분야에서만 사용되던 Fancy PCA가 학습 데이터셋 구축 단계에서 필연적으로 발생하는 한계를 극복하는 데 도움이 되었고, 이를 통해 2차원 재투영 오차. 그리고 ADD 지표에서 정확도가 향상되었다. 특히, 고정밀 지표인 5cm5deg에서 약 11 [%]의 정확도 향상이 있었는데, 이는 사용자에게 훨씬 안정적인 자세 추정 결과를 제공하는 것이 가능해졌다는 뜻과 같다. Fancy PCA는 학습 단계에서만 사용되므로 계산 속도의 변화는 없었고 가장 중요했던 것은 2차원 재투영 오차의 성능 향상이었다. 가상의 콘텐츠가 입력 이미지에 정확히 투영되어야 하는 MR 환경 개선과 더불어 시야의 가림없이 제공되는 몰입감 있는 새로운 경험은 선박, 제조, 생산 등의 분야에서도 적용될 수 있을 것이며, 작업 지시, 훈련, 정비 등의 보조 역할 수행의 핵심으로 적용될 것으로 예상한다.

References

[1] Bukschat, Yannick, and Marcus Vetter.

"EfficientPose: An efficient, accurate and scalable end-to-end 6D multi

object pose estimation approach." arXiv preprint arXiv:2011.04307 (2020).

[2] Krizhevsky, Alex, Ilya Sutskever, and

Geoffrey E. Hinton. "Imagenet classification with deep convolutional

neural networks." Advances in neural information processing systems 25

(2012).

[3] Tan, Mingxing, Ruoming Pang, and Quoc V.

Le. "Efficientdet: Scalable and efficient object detection."

Proceedings of the IEEE/CVF conference on computer vision and pattern

recognition. 2020.

[4] Lepetit, Vincent, Francesc Moreno-Noguer,

and Pascal Fua. "EP n P: An accurate O (n) solution to the P n P

problem." International journal of computer vision 81 (2009): 155-166.

대표이사: 유병현 / 사업자등록번호: 220-82-60063

Copyright© 2023. Society for Computational Design and Engineering. All rights